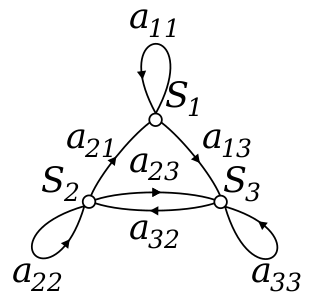

نمودار انتقال

چهار حالتی که در بالا به آن رسیده ایم را می توان در نمودار انتقال زیر به تصویر کشید :

این نمودار به سادگی هم سهم بازار هر برند و هم نرخ تغییر کاربران را نشان می دهد. برای اینکه بدانیم در یک ماه آینده این نمودار به چه شکلی در خواهد آمد باید چند تا محاسبه ساده مطابق زیر انجام دهیم :

سهم بازار (t+1) شرکت Pepsi = سهم فعلی بازارPepsi * نرخ ماندگاری مشتریان آن + سهم فعلی بازار Coke* نرخ ترک مشتریان Coke

سهم بازار (t+1) شرکت Coke= سهم فعلی بازار Coke * نرخ ماندگاری مشتریان آن + سهم فعلی بازار Pepsi* نرخ ترک مشتریان Pepsi

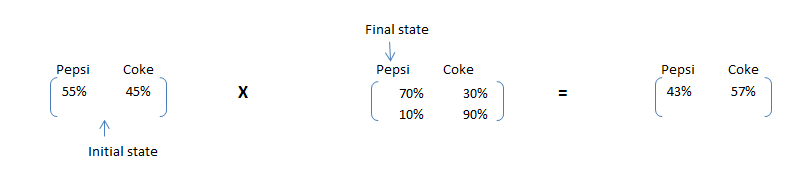

این محاسبات را می توانیم با ضرب ماتریس ها به صورت زیر هم انجام دهیم :

که ماتریس اول ، سهم اولیه بازار دو شرکت مورد مطالعه و ماتریس دوم ، ماتریس انتقال است . بنابراین همانطور که مشاهده می شود شرکت Coke در پایان یکماه ، سهم بازار بیشتری خواهد داشت . این محاسبه ساده ، به نام زنجیره مارکوف معروف است.

اگر این ماتریس انتقال در گذر زمان ثابت بماند، می توانیم سهم بازار شرکتها را در بازه های زمانی طولانیتر هم بررسی کنیم .

مثلا در پایان ماه دوم سهم بازار شرکتها از قرار زیر خواهد بود :

محاسبه حالت پایدار

شرکت Soda می خواهد بداند که در نهایت سهم بازار هر شرکت چقدر خواهد شد. سهم شرکت Pepsi همانطور که در محاسبات بالا مشاهده می کنید روبه نزول است اما نهایتا بازار به یک حالت ثابت و پایدار خواهد رسید که در آن تبادل و تغییر مشتریان دو شرکت در میزان سهم بازار آنها تاثیری نخواهد داشت یعنی مجموع مشتریان جداشده از شرکت اول با میزان مشتریان جداشده از شرکت دوم برابر خواهد شد . به این حالت، حالت پایدار می گوییم (Steady State)

برای یافتن این حالت از دو معادله دو مجهمولی زیر استفاده می کنیم :

۱- میزان سهم بازار شرکت Pepsi * ۳۰٪ = میزان سهم بازار شرکت Coke * ۱۰٪

۲- میزان سهم بازار شرکت Pepsi + سهم بازار شرکت Coke = ۱۰۰ ٪

با محاسبه مقدار سهم بازار شرکت Coke در فرمول اول و جایگزینی آن در فرمول دوم به معادله تک مجهولی زیر می رسیم

۴ * Pepsi = ۱۰۰٪ => سهم شرکت Pepsi = ۲۵٪ و سهم شرکت Coke = ۷۵ ٪

البته این معادله بسیار ساده بود و در مسایل دنیای واقعی پارامترها و تعداد مجهول ها بسیار بیشتر خواهد بود . برای به دست آوردن یک روش کاربردی برای محاسبه حالت پایدار، می توانیم از جبر ماتریسی کمک بگیریم :

ماتریس اولیه * ماتریس انتقال = ماتریس اولیه

که از این معادله ماتریسی می توان مجهولات که همان مقادیر ماتریس اولیه هستند را به کمک دستگاه معادلات خطی که بخشی از جبر خطی است، یافت .

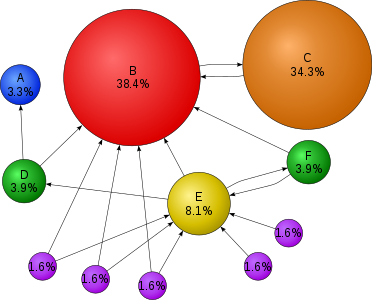

آشنايي با تئوري زنجيره ماركوف

زنجيره ماركوف، دنبالهاي از متغيرهاي تصادفي است كه همگي اين متغيرهاي تصادفي داراي فضاي نمونهاي يكسان هستند اما، توزيع احتمالات آنها ميتواند متفاوت باشد و در ضمن هر متغير تصادفي در يك زنجيره ماركوف تنها به متغير قبل از خود وابسته است. دنباله متغيرهاي تصادفي را بصورت زير نمايش ميدهيم:

![]()

فضاي نمونهاي متغيرهاي تصادفي زنجيره ماركوف ميتواند پيوسته يا گسسته، محدود يا نامحدود باشد. براي ادامه بحث حالت گسسته و محدود را درنظر ميگيريم هرچند مطالب گفتهشده قابل تعميم به حالت پيوسته نيز ميباشد.

با فرض حالت گسسته محدود براي فضاي نمونهاي، ميتوان هر متغير تصادفي را با توزيع احتمالش نمايش داد. اين توزيع را با يك بردار كه احتمال هر كدام از مقادير فضاي نمونهاي را در خود جاي داده است، نمايش ميدهيم. بنابراين، نمايش ديگر زنجيره ماركوف عبارتست از:

![]()

![]()

با توجه به تعريف زنجيره ماركوف، دانستن اولين مولفه زنجيره و رابطهاي كه مولفه i-ام را از مولفه (i-1)-ام توليد ميكند، براي ساختن زنجيره كافيست. اين رابطه را تابع تبديل (T) ميگوييم و نحوه بدست آوردن مولفههاي بردار احتمال بوسيله اين تابع عبارتست از:

![]()

چنانچه در زنجيره ماركوف، رابطه بين متغيرهاي تصادفي متوالي به موقعيت آنها در زنجيره وابسته نباشد، زنجيره را همگن ميگوييم. در يك زنجيره همگن:

![]()

ميتوان روابط گفتهشده را بصورت رابطه ماتريسي زير خلاصه نمود:

![]()

با استفاده مكرر از رابطه بالا، ميتوان نوشت:

![]()

چنانچه دو عنصر متوالي از زنجيره ماركوف همگن، يكسان گردند، تمامي عناصر بعدي نيز يكسان خواهند بود و ميگوييم زنجيره همگرا شده است، در اين حالت خواهيم داشت:

![]()

ميتوان، انواع مختلفي از زنجيرههاي ماركوف تعريف كرد و همگرايي آنها را با استدلالات رياضي بررسي نمود.

زنجيره ماركوف، را ارگوديك ميگوييم اگر:

يك زنجيره ماركوف ارگوديك، تنها ميتواند به يك توزيع همگرا شود كه توزيع سكون (equilibrium)خوانده ميشود و اين مستقل از اولين عنصر زنجيره است. برخي زنجيرهها، پريوديك هستند، برخي تضمين همگرايي ندارند و برخي ارگوديك هستند. از اين ميان زنجيرههاي ماركوف ارگوديك هستند كه در تئوري نمونهبرداري كاربرد فراوان دارند.

در اينجا، پرسشي مطرح ميشود كه چه موقع يك زنجيره ماركوف ارگوديك است؟ در اين ضمينه قضاياي رياضي وجود دارد كه معروفترين آنها، قضيه اساسي نام دارد. بر طبق اين قضيه يك زنجيره ماركوف همگن، ارگوديك است اگر:

![]()

برای دریافت اطلاعات تکمیلی فایل زیر را دانلود و مشاهده فرمایید.

رمز فایل : behsanandish.com

زنجیره مارکوف (Markov Approach modeling) قسمت 1

زنجیره مارکوف (Markov Approach modeling) قسمت 2

زنجیره مارکوف (Markov Approach modeling) قسمت 3

زنجیره مارکوف (Markov Approach modeling) قسمت 4

زنجیره مارکوف (Markov Approach modeling) قسمت 5

![{\displaystyle H_{ij}=E[T_{ij}]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/7534400c9445d555950b49a2d86f7bcf4389ee29)

![{\displaystyle p_{ij}^{(n)}=[P^{n}]_{ij}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/dd3b38dcfe4aa747f5765dbfa1368ae661c7fb65)

![{\displaystyle M_{i}=E[T_{i}]=\sum _{n=1}^{\infty }n\cdot f_{ii}^{(n)}.\,}](https://wikimedia.org/api/rest_v1/media/math/render/svg/e7182ea52ad054b13097e3b47c7f38fa22bdca87)