مقالات پیرامون تشخیص اعداد و حروف دست نویس فارسی

1. ارائه یک روش ساختاری جدید مبتنی بر قطعه بندی تصویر نازک شده برای شناسایی اعداد دست نویس فارسی/عربی

چکیده- در این مقاله، یک روش ساختاری جدید برای استخراج ویژگی از اعداد فارسی/عربی دست نوشته، ارائه شده است. پس از پیش پردازش اولیه و تبدیل تصویر به تصویر باینری، ابتدا رقم دست نوشته، نازک شده و اسکلت آن از تصویر استخراج می شود. سپس نقاط مهم تصویر به دست آمده مشخص می شوند. رقم نازک شده به قطعه خط هایی تقسیم می شود و از هر قطعه، کدهای اولیه استخراج می شود. در نهایت یک بردار ویژگی به دست می آید که طول آن به تعداد قطعه خط ها بستگی دارد. یک مقایسه بین روش ساختاری ارائه شده و روش های آماری دیگر مانند روش های مبتنی بر تبدیل موجک، فرکتال و زرنیک، از نظر زمانی و درصد تشخیص انجام شده است. نتایج نشان می دهند که عملکرد این ویژگیهای ساختاری بسیار بهتر از ویژگی های آماری است. درصد تشخیص با این ویژگی ها و با طبقه بندی کننده مبتنی بر نزدیکترین همسایه، 94/44% به دست آمد. این آزمایشات بر روی دادگانی شامل 480 نمونه برای هر رقم انجام شد که 280 نمونه برای آموزش و 200 نمونه برای آزمایش به کار گرفته شدند.

کلمات کلیدی- روش ساختاری جدید، تشخیص دست نوشته، اعداد فارسی

فایل PDF – در 7 صفحه- نویسندگان: مجید زیارت بان، کریم فائز، سعید مظفری، مهدی ازوجی

ارائه یک روش ساختاری جدید مبتنی بر قطعه بندی تصویر نازک شده برای شناسایی اعداد دست نویس فارسی یا عربی

پسورد فایل : behsanandish.com

2. بازشناسی برخط حروف مجزای فارسی با شبکه عصبی

چکیده- در این مقاله روشی برای بازشناسی برخط حروف مجزای فارسی با شبکههای عصبی ارائه می شود. پس از بازشناسی علامت های بالا یا پایین حرف ناشناخته، بدنه ی حرف از نظر تعداد نقاط و اندازه نرمالیزه می شود و مختصات نقاط بدنه ی نرمالیزه شده به عنوان ورودی یک شبکه ی عصبی سه لایه در نظر گرفته می شود و بدنه ی حرف ناشناخته بازشناسی می شود. میزان بازشناسی درست برای 4144 حرف، 93/9% است.

واژه های کلیدی- بازشناسی برخط، حروف مجزا،شبکه ی عصبی

فایل PDF – در 7 صفحه- نویسندگان: سید محمد رضوی، احسان اله کبیر

بازشناسی برخط حروف مجزای فارسی با شبکه عصبی

پسورد فایل : behsanandish.com

3. کاربرد ترکیب طبقه ها در بازشناسی ارقام فارسی

چکیده- در این تحقیق، برای بهبود بازشناسی ارقام دستنویس از ترکیب طبقه بندی هایی استفاده می شود که از یک الگوریتم یادگیری دو مرحله ای بهره می گیرند. از تصویر هر رقم دستنویس، یک بردار ویژگی با 81 مؤلفه استخراج می شود. به روش تحلیل مؤلفه های اصلی، یک بردار ویژگی با پانزده مؤلفه برای هر رقم انتخاب شده و به سه شبکه عصبی پرسپترون با تعداد نرون های متفاوت در لایه مخفی و وزن های اولیه متفاوت اعمال شده و بازشناسی مستقل در هر طبقه بند صورت می گیرد. در مرحله بعد، نتایج بازشناسی این سه طبقه بند، به یک شبکه عصبی پرسپترون با یک لایه مخفی به عنوان ترکیب کننده اعمال می شود.

پایگاه داده استفاده شده شامل 2430 نمونه است. نرخ بازشناسی شبکه های عصبی پایه بر روی 530 نمونه آزمایشی 87% ، 85% و 83% و برای سیستم مرکب 91% است.

واژه های کلیدی- بازشناسی ارقام، ترکیب طبقه بندها، شبکه عصبی پرسپترون، مکان مشخصه، تحلیل مؤلفه های اصلی.

فایل PDF – در 5 صفحه- نویسندگان: سید حسن نبوی کریزی، رضا ابراهیم پور، احسان اله کبیر

کاربرد ترکیب طبقه ها در بازشناسی ارقام فارسی

پسورد فایل : behsanandish.com

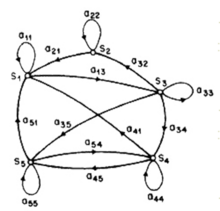

4. بازشناسی حروف برخط فارسی با استفاده از مدل مخفی مارکوف

چکیده- در این مقاله، روشی برای بازشناسی حروف برخط فارسی که به صورت تنها نوشته شده اند، معرفی شده است. با توجه به شکل و ساختار بدنه اصلی، حروف فارسی به 17 گروه تقسیم می شوند. ابتدا، با استفاده از روش آماری مدل مخفی مارکوف به بازشناسی بدنه اصلی پرداخته شده است. در گام بعدی، بازشناسی نهایی در هر گروه با توجه به موقعیت علائم، نقاط و مدل مخفی مارکوف آن ها انجام شده است. روش پیشنهادی بر روی مجموعه داده “حروف برخط دانشگاه تربیت مدرس” اجرا شده و گروه بندی درست با دقت 96% و بازشناسی حروف با دقت 94% به دست آمده است.

کلمات کلیدی- دستنوشته برخط، فارسی، بازشناسی، مدل مخفی مارکوف.

فایل PDF – در 6 صفحه- نویسندگان: وحید قدس، احسان اله کبیر

بازشناسی حروف برخط فارسی با استفاده از مدل مخفی مارکوف

پسورد فایل : behsanandish.com

5.بازشناسی ارقام دستنویس فارسی مقاوم در برابر چرخش و تغییر مقیاس توسط طبقه بندی کننده SVM فازی مبتنی بر خوشه بند K-means

چکیده- در این مقاله روشی را برای تشخیص این ارقام معرفی کردیم که در برابر چرخش و تغییر مقیاس تا حد قابل قبولی مقاوم می باشد. در این مقاله هم برای استخراج ویژگی و هم برای طبقه بندی از دو روش مجزا استفاده کردیم. در مرحله اول برای استخراج ویژگی از آنالیز اجزای اصلی (PCA) استفاده کرده و در نوع دیگری از استخراج ویژگی از آنالیز تفکیک کننده ی خط (LDA) که برای کاهش ابعاد LDA، از تکنینک PCA استفاده کردیم. این ویژگی ها را با طبقه بندی کننده ی MLP و Fuzzy SVM به صورت جداگانه کلاسه بندی کردیم و نتایج را با هم مقایسه کردیم. برای نمایش اینکه روشمان در برابر چرخش و تغییر مقیاس مقاوم می باشد، 30 درصد کل ارقام پایگاه داده مان که متشکل از 860 رقم برای هر کدام از ارقام 0 تا 9 می باشد را با زاویه های مختلف به صورت تصادفی در جهت یا خلاف جهت عقربه ساعت چرخانه و نتایج به دست آمده را با حالت بدون چرخش مقایسه کردیم. نرخ بازشناسی روش پیشنهادی بر روی 7600 نمونه آزمایشی در حالت بدون چرخش، 97/3% به دست آمده که نسبت به نرخ بازشناسی همین پایگاه داده، در [1] و [2] به ترتیب 15/4% و 1/9% بهبود را نشان می دهد.

کلمات کلیدی- ارقام دستنویس، PCA-LDA، Fuzzy SVM، MLP، PCA

فایل PDF – در 6 صفحه- نویسنده: مهدی صالح پور

بازشناسی ارقام دستنویس فارسی مقاوم در برابر چرخش و تغییر مقیاس توسط طبقه بندی کننده SVM فازی مبتنی بر خوشه بند K-means

پسورد فایل : behsanandish.com

6. بررسی تأثیر ارتقاء تصویر و اصلاح شیب در بهبود نرخ بازشناسی ارقام جدا شده از اسناد دست نویس فارسی

چکیده- در این مقاله برای اولین بار میزان تأثیر ارتقاء تصویر و اصلاح شیب موجود در ارقام دست نویس فارسی، بر بهبود نرخ بازشناسی ارقام مورد بررسی قرار گرفته است. در ابتدا به دلیل اینکه جداسازی ارقام از تصاویر اسناد دست نویس منجر به ایجاد شکاف هایی در تصاویر ارقام جدا شده می شود، از عنصر ساختاری مناسبی برای ارتقاء تصاویر استفاده شده است. در گام بعدی، شیب موجود در ارقام، تخمین زده شده و اصلاح می گردد. بانک اطلاعاتی استفاده شده در این مقاله شامل ارقام جدا شده (4096 رقم در مجموعه آموزشی و 1532 رقم در مجموعه آزمایشی) از فرم هایی با پس زمینه ی رنگی است که توسط 500 نویسنده پر شده اند. آزمایشات انجام شده نشان می دهد که ارتقاء تصویر و اصلاح شیب در مرحله پیش پردازش، به طور میانگین نرخ بازشناسی را به میزان 3/3 درصد افزایش می دهد که نشان دهنده ی کارآمدی گام های پیشنهادی( ارتقاء تصویر و اصلاح شیب) در مرحله پیش پردازش است.

کلمات کلیدی- ارتقاء تصویر، عنصر ساختاری، اصلاح شیب، ماتریس شکاف، بازشناسی ارقام دست نویس فارسی.

فایل PDF – در 5 صفحه- نویسندگان: یونس اکبری، محمدجواد جلیلی، عاطفه فروزنده، جواد صدری

بررسی تأثیر ارتقاء تصویر و اصلاح شیب در بهبود نرخ بازشناسی ارقام جدا شده از اسناد دست نویس فارسی

پسورد فایل : behsanandish.com

![{\displaystyle \ A=[a_{ij}]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/8c2e5be58535cfa69a95badb38fd3533bfb6235e)